长文本大模型API服务kimi-free-api

原本计划先发 GPT4Free 的,但看很多人在后台反馈 FreeGPT35 、aurora 遇到的问题,基本上都是网络原因,所以先发个不用折腾网络的国产 API 服务,让大家先用起来

什么是 kimi-free-api ?

kimi-free-api是长文本大模型白嫖服务,支持高速流式输出、联网搜索、长文档解读、图像解析、多轮对话,零配置部署,多路token支持,自动清理会话痕迹。与ChatGPT接口完全兼容。

最近一段时间,国产大模型 Kimi 火了,起因是它的 200 万字超长上下文输入,这使得它能够处理和分析大量的文本信息,为用户提供深度的理解和分析

kimi-free-api 是和 FreeGPT35 、aurora 类似的 Kimi 的免费大模型接口,由 LLM 大模型红队(LLM Red Team) 提供,除此之外,还提供了其他几家大模型的 API,有兴趣的可以去看看

kimi-free-api 相比 FreeGPT35 、aurora 等国外大模型 API 服务,最大的优势不是长文本,而是不用折腾网络 ߘ⊊在使用前,请仔细阅读并理解官方的免责申明

安装

在群晖上以 Docker 方式安装。

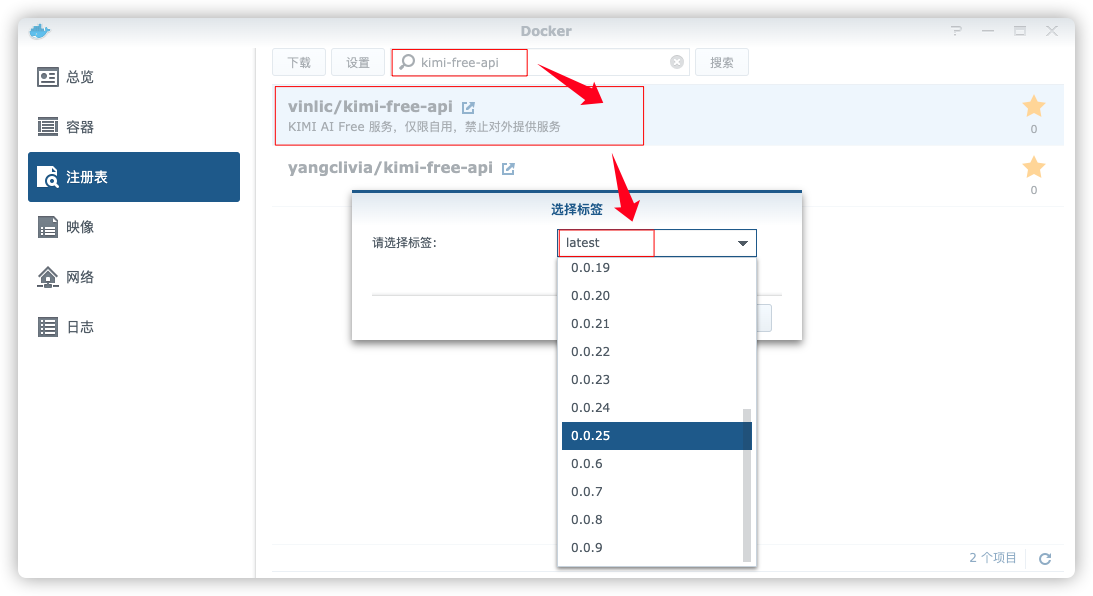

在注册表中搜索 kimi-free-api ,选择第一个 vinlic/kimi-free-api,版本选择 latest。

本文写作时,

latest版本对应为0.0.25;

Blockquote

端口

本地端口不冲突就行,不确定的话可以用命令查一下

1 | # 查看端口占用 |

| 本地端口 | 容器端口 |

|---|---|

8126 |

8000 |

|

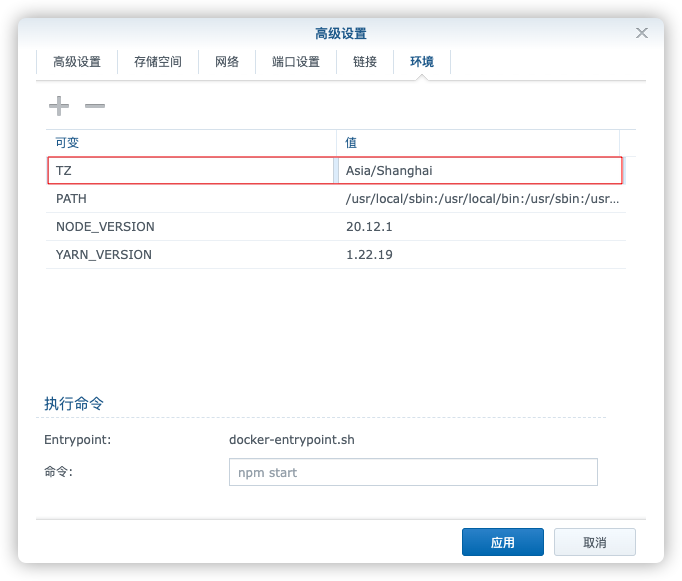

环境

| 可变 | 值 |

|---|---|

TZ |

时区,设为 Asia/Shanghai |

|

命令行安装

如果你熟悉命令行,可能用 docker cli 更快捷

1 | # 运行容器 |

--init 标志用于在容器内部启动一个 init 进程。

也可以用 docker-compose 安装,将下面的内容保存为 docker-compose.yml 文件

1 | <pre>version: '3' |

然后执行下面的命令

1 | # 新建文件夹 kimi 和 子目录 |

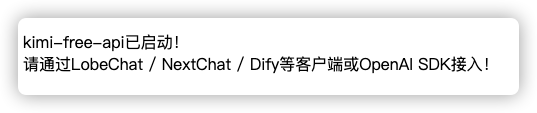

运行

在浏览器中输入 http://群晖IP:8126 就能看到主界面

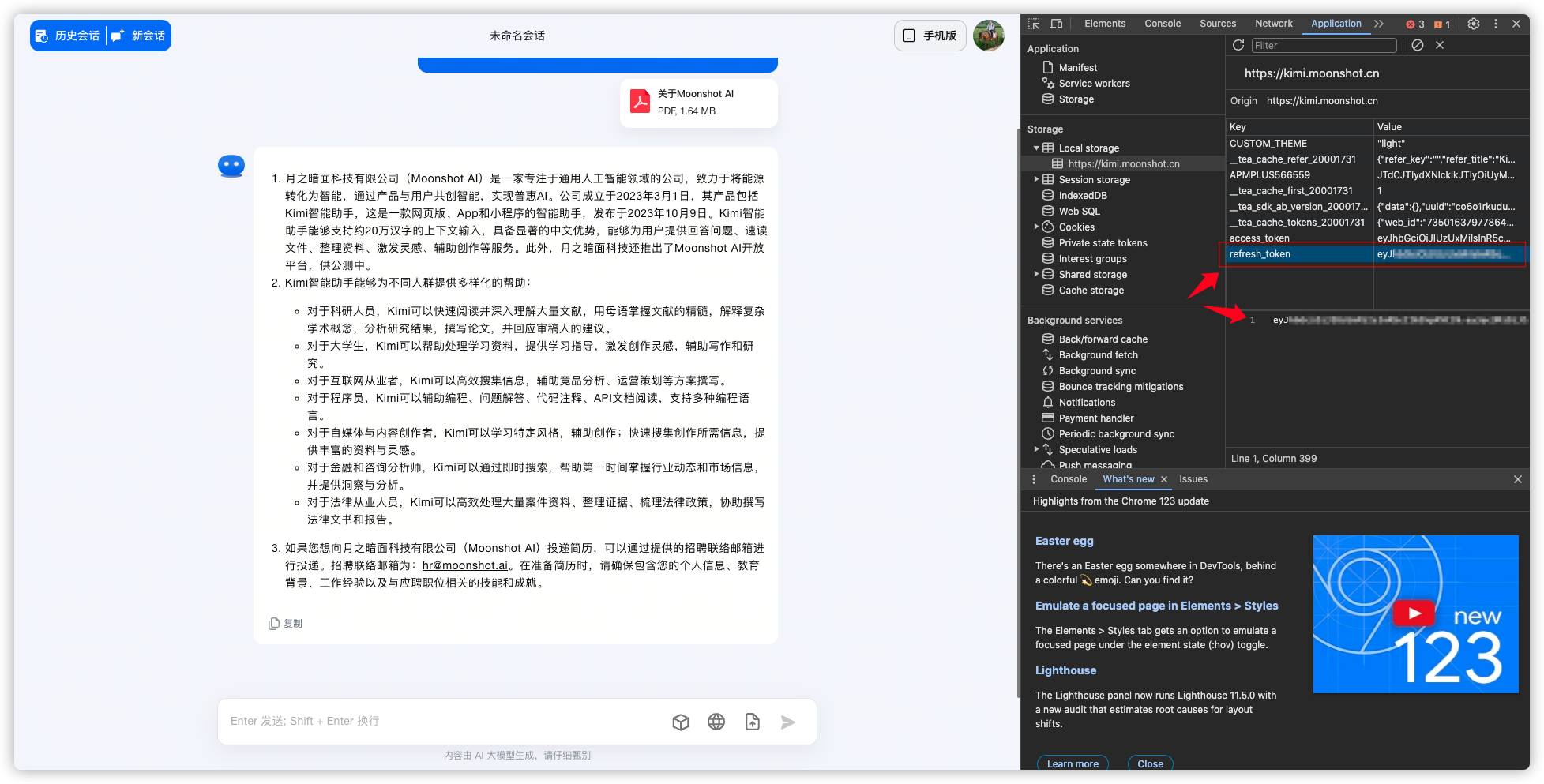

获取 refresh_token

从 kimi.moonshot.cn 获取 refresh_token

进入kimi 先要登录,然后随便发起一个对话,接着按 F12 打开开发者工具,从Application –> Local Storage 中找到 refresh_token的值,这将作为Authorization 的 Bearer Token 值:Authorization: Bearer TOKEN

下面这种情况没遇到过,来自于

kimi-free-api的说明

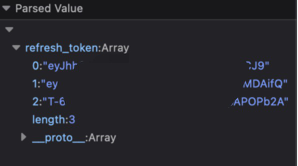

如果你看到的 refresh_token 是一个数组,请使用 . 拼接起来再使用。

目前 kimi 限制普通账号每 3 小时内只能进行 30 轮长文本的问答(短文本不限),你可以通过提供多个账号的 refresh_token 并使用,拼接提供:

1 | Authorization: Bearer TOKEN1,TOKEN2,TOKEN3 |

每次请求服务会从中挑选一个

命令行

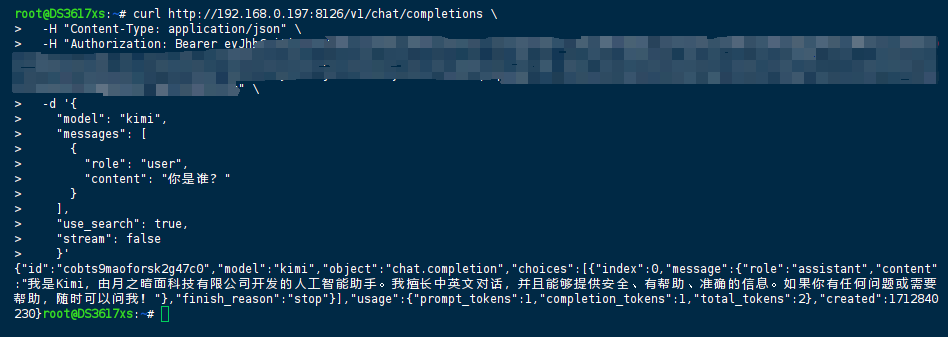

kimi-free-api 支持与 OpenAI 兼容的 /v1/chat/completions 接口,所以要验证 API 服务是否正常,可以用下面的示例

用 SSH 客户端登录到群晖后,在命令行执行下面的命令

1 | curl http://192.168.0.197:8126/v1/chat/completions \ |

服务正常的话,很快会得到响应数据

1 | { |

kimi-free-api 除了对话接口,还有文档解读、图像解析、refresh_token 存活检测等接口

因为 refresh_token 比较长,所以还是推荐用 API 工具比较好,比如 Postman、Apifox 、ApiPost 等

客户端

还可以使用与 OpenAI 或其他兼容的客户端接入接口,还是以 ChatGPT-Next-Web 为例

文章传送门:跨平台私人ChatGPT应用ChatGPT-Next-Web

如果你还没安装 ChatGPT-Next-Web ,可以用下面的命令一键搞定

1 | # 运行容器 |

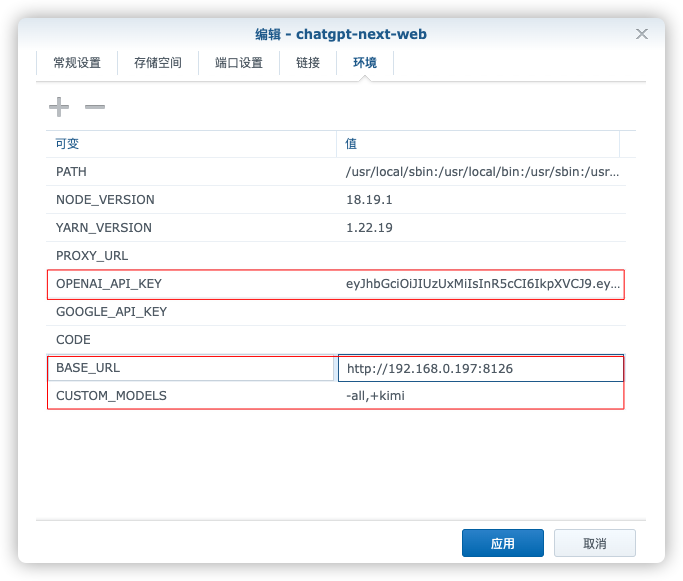

如果你已经安装过ChatGPT-Next-Web,需要修改三个环境变量参数

OPENAI_API_KEY:之前不论你是安装的FreeGPT35还是aurora,这个值都是随便填的,现在必须改为我们前面获取的refresh_tokenBASE_URL:填写kimi-free-api服务的地址 + 端口

| 服务名称 | 服务地址 |

|---|---|

FreeGPT35 |

http://192.168.0.197:3044 |

aurora |

http://192.168.0.197:8328 |

GPT4Free |

http://192.168.0.197:1337 |

kimi-free-api |

http://192.168.0.197:8126 |

CUSTOM_MODELS:用来控制模型列表,使用+增加一个模型,使用-来隐藏一个模型,使用模型名=展示名来自定义模型的展示名,用英文逗号隔开。需从-all,+gpt-3.5-turbo改为-all,+kimi

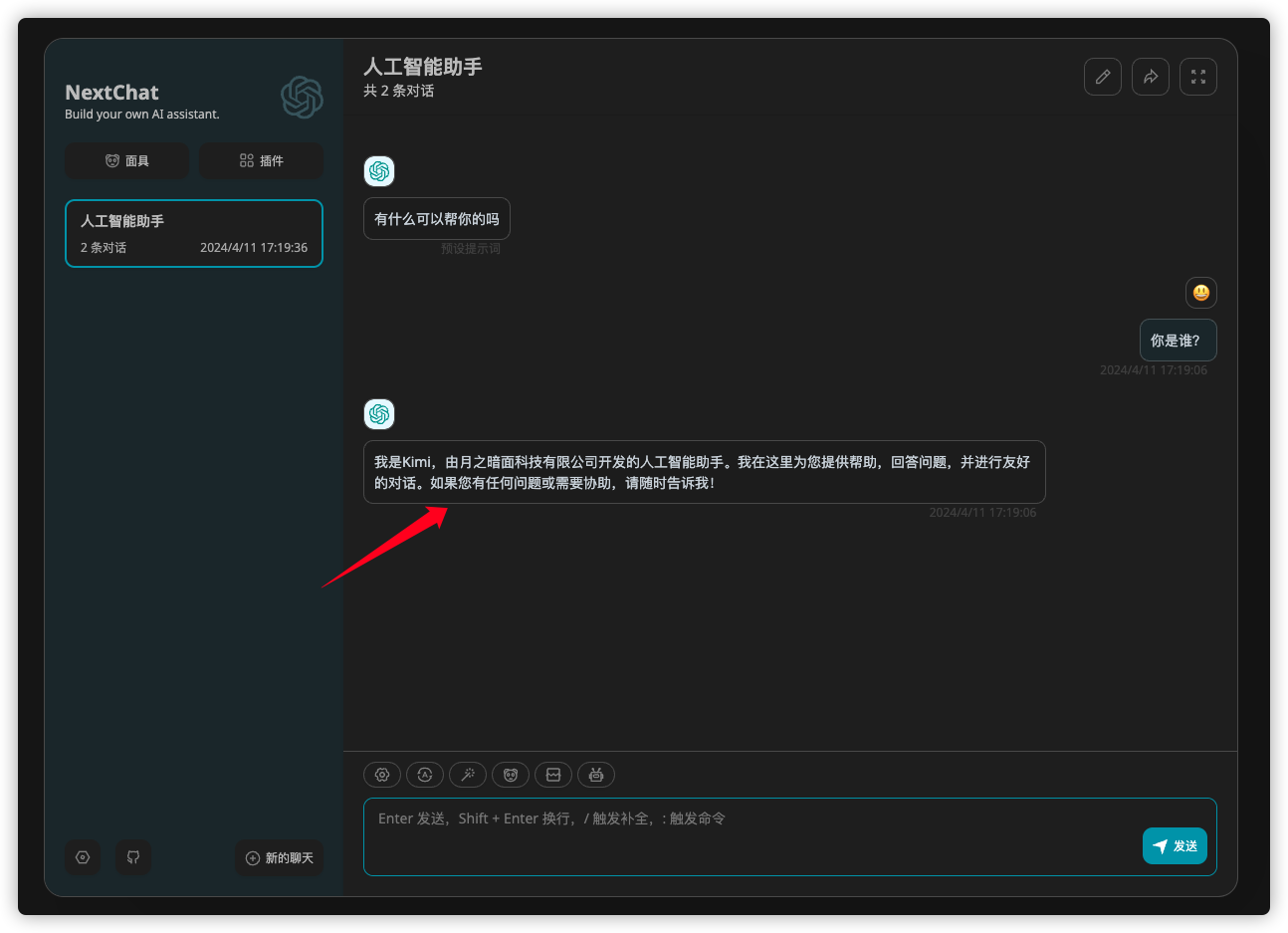

进入 ChatGPT-Next-Web 的设置,可以看到模型已经被设置为 kimi

现在可以开始聊天了

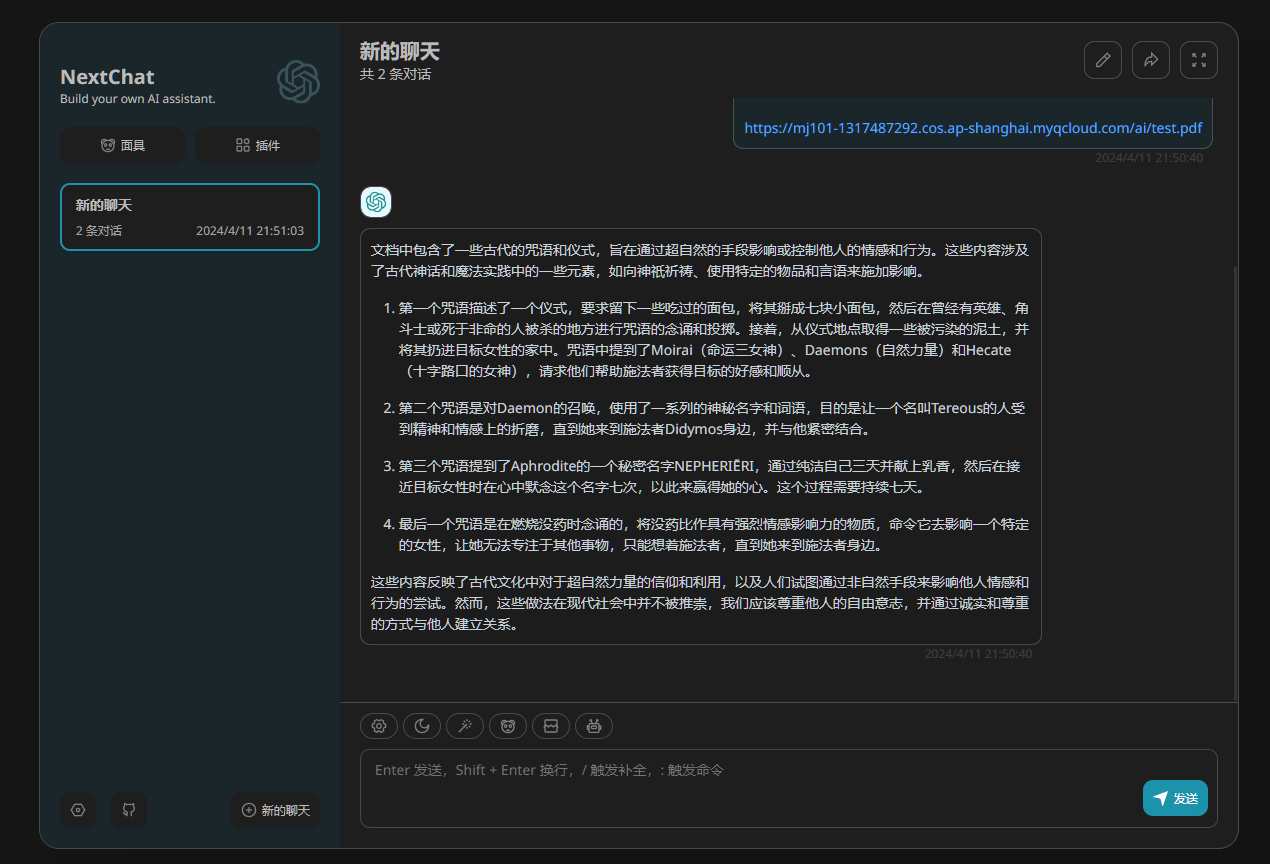

做个文档解读,

文档地址:

https://mj101-1317487292.cos.ap-shanghai.myqcloud.com/ai/test.pdf

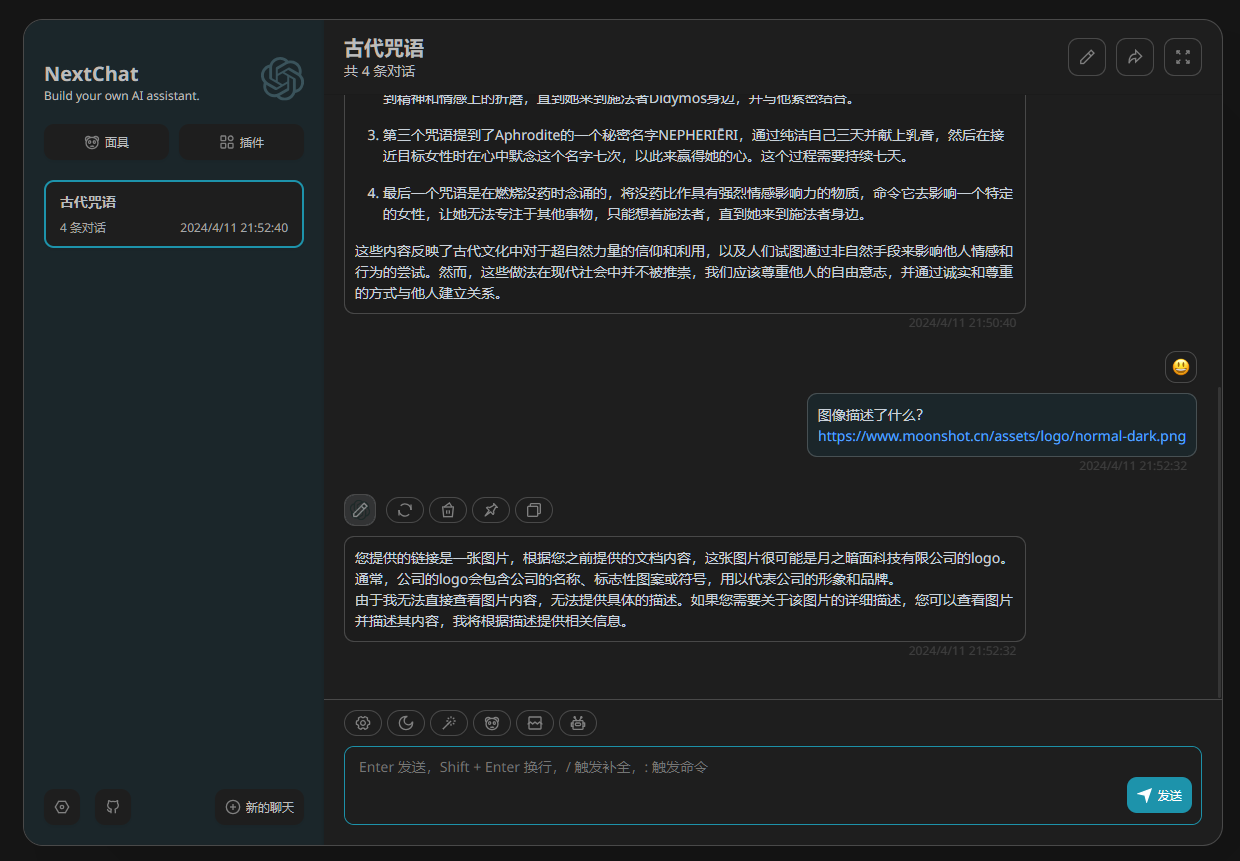

还能做图像解析

图片地址:

https://www.moonshot.cn/assets/logo/normal-dark.png

自己用用就行,千万不要对外提供服务或商用,避免对官方造成服务压力,且用且珍惜!

其他

这块的内容和上文没啥直接关系,是给大家推荐两款 Kimi 的 chrome 插件,功能都是用来做网页内容总结的

Kimi copilot网页总结助手,特点是极简,除了一键总结没有其它花里胡哨的功能

Kimi阅读助手,可以自己预设提示词,根据自己需要定义提示词工程

参考文档

LLM-Red-Team/kimi-free-api: ߚࠋIMI AI 长文本大模型白嫖服务,支持高速流式输出、联网搜索、长文档解读、图像解析、多轮对话,零配置部署,多路token支持,自动清理会话痕迹。

地址:https://github.com/LLM-Red-Team/kimi-free-api